Bahía de Georgia – Paisaje de verano

Cambiando cómo se toman las fotografías

En los últimos años, varios fabricantes han producido cámaras que son capaces de producir imágenes de mayor resolución a través de algo llamado tecnología Sensor-Shift. Esta tecnología ha sido posible con la llegada de la estabilización de imagen corporal (IBIS). Los diseñadores de cámaras han utilizado el IBIS como una forma de obtener aumentos increíbles en la resolución de la imagen o para mejorar la información de color de las imágenes que se toman.

Hay una serie de nombres para esta tecnología, incluidos el modo de alta resolución, el sistema de resolución de cambio de píxeles, el modo de disparo múltiple con cambio de píxeles o los nombres más genéricos de cambio de píxeles/cambio de sensor, pero al final, los conceptos detrás de esta tecnología son todos lo mismo. Se toman varias imágenes de la misma vista de tal manera que las imágenes se apilan y combinan para crear una sola imagen, generalmente grande, de alta resolución.

Hay fortalezas y debilidades de esta nueva tecnología y comprender cómo funciona puede ayudarlo a obtener mejores imágenes usted mismo si tiene una cámara capaz de hacerlo.

Gerberas en interiores, resolución regular (20 MP) Olympus OMD EM 1 Mark II

Gerberas en interiores, alta resolución (50MP) Olympus OMD EM 1 Mark II

Muchas aproximaciones a las imágenes de cambio de sensor

La captura de imágenes con cambio de sensor ha pasado de ser costosas cámaras especializadas a convertirse en una función cada vez más disponible en las cámaras más nuevas orientadas a la resolución. Actualmente, además de la monstruosa H6D-400c de Hasselblad (imágenes de 400 megapíxeles), hay ofertas de Olympus, Pentax, Sony y Panasonic.

Estas versiones generalmente usan el mismo enfoque conceptual pero a precios mucho más accesibles.

Movimiento de cambio de sensor

¿Quién usa Sensor-Shift?

Independientemente del fabricante, la acción básica de la captura de imágenes con cambio de sensor sigue siendo la misma. Tome varias imágenes pero mueva el sensor de la cámara ligeramente para cada imagen para capturar más datos de imagen y luego junte la imagen.

Al mover el sensor, los datos de color de la imagen mejoran, lo que permite resolver más detalles al superar los problemas inherentes con los sitios de fotos de colores específicos. Ignorando a Hasselblad, los sistemas que utilizan esta tecnología incluyen cámaras como la Olympus OM-D E-M1 Mark II (Micro Four Thirds), Pentax K-1 Mark II DSLR, Sony a7R III y Panasonic Lumix DC-G9 (Micro Four Thirds). Four Thirds) aunque existen otros de los mismos fabricantes.

Tres de estas líneas son cámaras sin espejo y la Pentax es una DSLR con sensor de recorte. Es interesante notar que las cámaras Panasonic/Olympus adoptan un enfoque y Pentax/Sony adoptan un enfoque diferente a los mismos conceptos.

Los sistemas Olympus/Panasonic utilizan un enfoque que crea imágenes muy grandes de alta resolución, mientras que los sistemas Pentax y Sony utilizan el cambio de sensor para mejorar la información de color de imágenes del mismo tamaño. Los sistemas Pentax y Sony también permiten la separación de las imágenes individuales desplazadas por el sensor, mientras que Olympus y Panasonic combinan las imágenes apiladas en una sola fotografía.

Olympus OMD EM5 Mark II tiene la tecnología de cambio de sensor.

¿Cómo funciona la tecnología de sensores?

Para comprender cómo funciona la tecnología de cambio de sensor, también debe comprender cómo funciona un sensor en general a una escala muy pequeña. En los viejos tiempos de la fotografía con película, las cámaras usaban película sensible a la luz para grabar imágenes. Las cámaras digitales utilizan un enfoque muy diferente para registrar la luz.

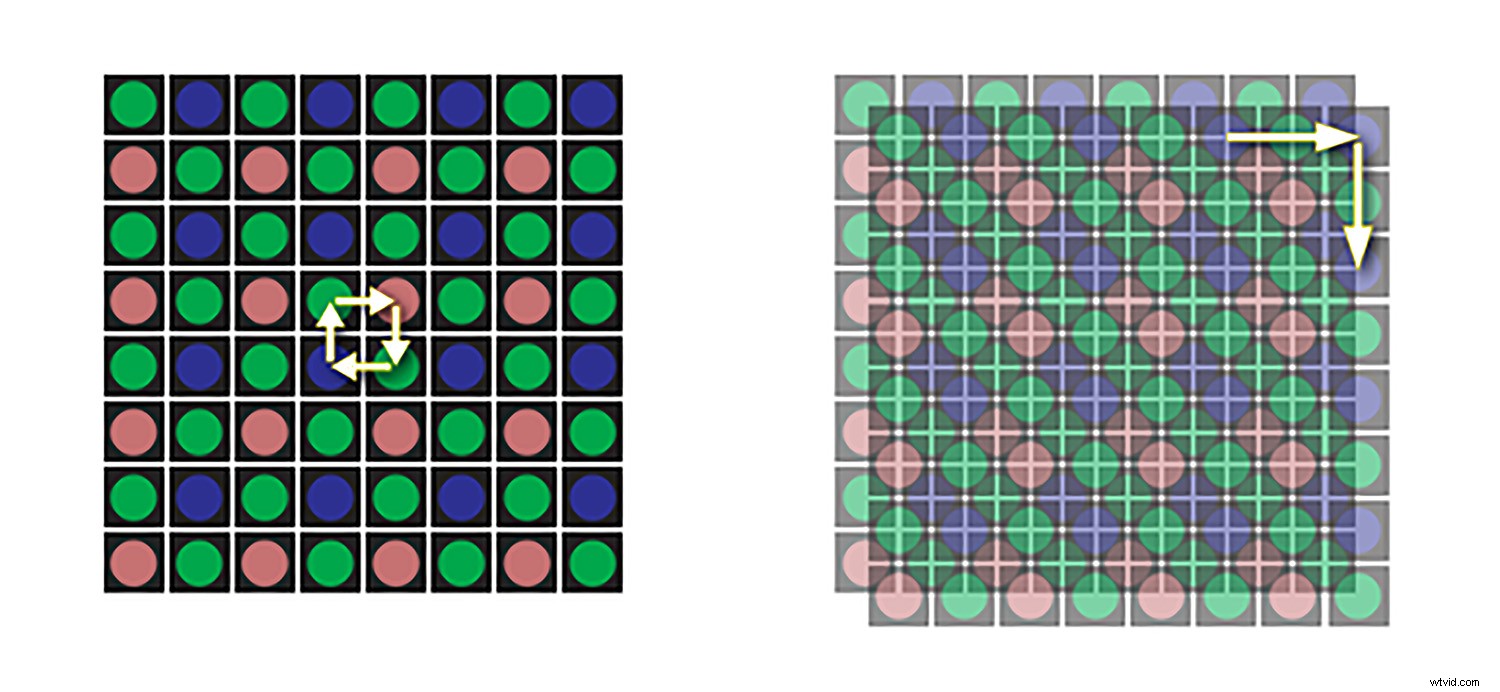

Las cámaras digitales utilizan fotodiodos sensibles a la luz para registrar la luz que incide en el sensor. En la mayoría de las cámaras digitales, cada fotodiodo tiene un filtro de color específico (rojo, verde o azul), formando un fotosito. Estos sitios de fotos están dispuestos para permitir que la luz se mezcle para ver el color de la imagen que llega al sensor.

Los sitios de fotos rojos, verdes y azules en un sensor generalmente se organizan en un patrón específico conocido como matriz de Bayer (también conocida como matriz de Bayer, filtro). También hay otras configuraciones como el sensor Fuji X-Trans (usado en varios de sus modelos de cámara) o Sigma que usa un sensor Foveon.

Con un arreglo de Bayer, hay el doble de fotositos verdes que rojos o azules porque la visión humana está más sintonizada para resolver los detalles en verde. Esta disposición generalmente funciona bien, pero si lo piensa bien, en una imagen, se crea un píxel de color al combinar estos sitios de fotos.

El sensor no sabe cuánto rojo hay en una ubicación de sensor verde o en una ubicación de sensor azul, por lo que se requiere interpolación. Esto puede crear algunos artefactos en las fotografías si miras muy de cerca y tiende a significar que las imágenes RAW tienen un enfoque levemente suave. Todas las imágenes RAW necesitan algo de nitidez en el posprocesamiento (el verde, el rojo y el azul de un píxel se mezclan).

Patrón de fotositos de Bayer

Sensores estáticos

En una cámara normal sin IBIS, cada fotosito solo registra la luz de un color en ese punto, por lo que los datos que registra son técnicamente incompletos. Es como un balde que solo recoge la luz de un color en particular. Se utiliza un grupo de cubos de luz en el patrón de Bayer para crear un solo píxel en la imagen digital, pero dentro de ese píxel hay dos cubos verdes, uno azul y otro rojo.

Para fusionar la imagen y poner un solo color en ese píxel, las señales del grupo de fotodiodos se resuelven juntas. Los datos recopilados se interpolan a través de un algoritmo de eliminación de mosaicos ya sea en la cámara (jpeg) o en una computadora (a partir de una imagen RAW), un proceso que asigna valores para los tres colores para cada sitio de fotos en función de los valores colectivos registrados por los sitios de fotos vecinos. .

Los colores resultantes luego se emiten como una cuadrícula de píxeles y se crea una fotografía digital. Esta es en parte la razón por la cual las imágenes RAW tienen un enfoque ligeramente más suave y deben enfocarse en el flujo de trabajo de posproducción.

Sensores de movimiento

IBIS significa que los sensores ahora se mueven muy levemente para ajustarse a los movimientos sutiles de una cámara para mantener la imagen estable. Algunos fabricantes afirman que sus sistemas son capaces de estabilizar la combinación de sensor y/o lente por un equivalente de 6,5 paradas.

Mover el sensor permite que todos los sitios de fotos en color registren los datos de cada ubicación en el sensor.

Esta estabilización se logra mediante microajustes de la posición del sensor. Para las imágenes de cambio de sensor, esos mismos microajustes se utilizan para exponer cada sitio de fotos a la luz de la grabación de una sola imagen. En esencia, el sensor no se mueve para ajustarse a las perturbaciones externas, sino para que cada parte de una imagen contenga información a todo color.

Fotositios en lugar de píxeles

Es posible que haya notado el término fotositos en lugar de píxeles. Las cámaras a menudo se clasifican por sus megapíxeles como una medida de su poder de resolución, pero esto es confuso porque las cámaras en realidad no tienen píxeles, solo fotos.

Los píxeles están en la imagen producida cuando se procesan los datos del sensor. Incluso el término "desplazamiento de píxeles" que se utiliza a veces es engañoso. Los píxeles no se mueven, son los sensores que tienen fotositos los que se mueven.

En la captura de una sola imagen, cada fotositio registra datos de luz roja, verde o azul. Estos datos son interpolados por una computadora para que cada píxel en la fotografía digital resultante tenga un valor para los tres colores.

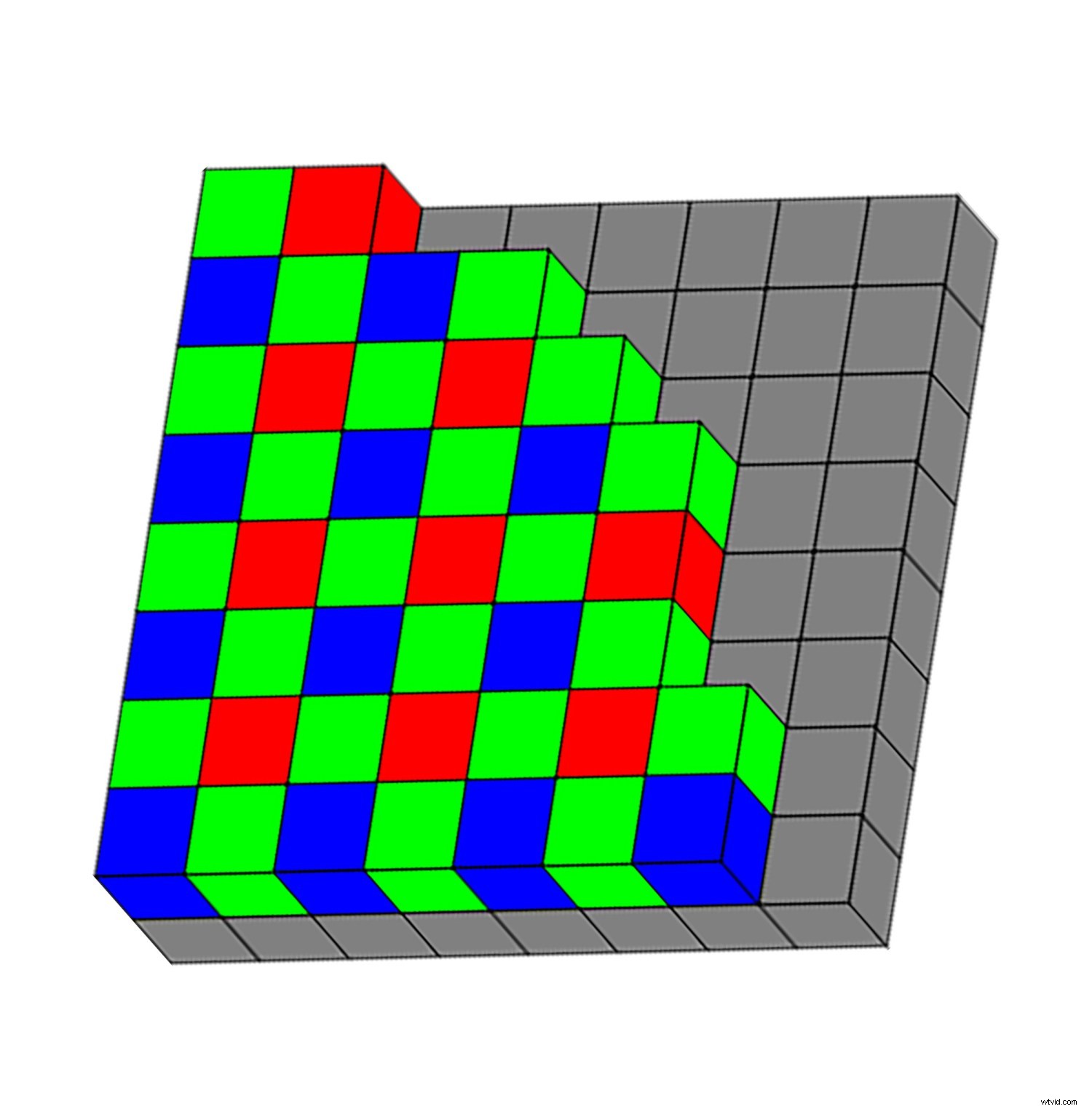

Sensores de cambio

Las cámaras de cambio de sensor intentan reducir la dependencia de la interpolación capturando datos de color para rojo, verde y azul para cada píxel resultante moviendo físicamente el sensor de la cámara. Considere un cuadrado de 2×2 píxeles tomado de una fotografía digital.

La captura digital convencional con una matriz de Bayer registrará datos de cuatro sitios de fotos:dos verdes, uno azul y uno rojo. Técnicamente, eso significa que faltan datos de luz azul y roja en los sitios de fotos verdes, datos verdes y rojos en los sitios de fotos azules y azul y verde en los sitios de fotos rojos. Para solucionar este problema, los valores de color faltantes para cada sitio se determinarán durante el proceso de interpolación.

Pero, ¿y si no tuvieras que adivinar? ¿Qué pasaría si pudieras tener el color real (rojo, azul y verde) para cada sitio de fotos? Este es el concepto detrás de la tecnología de cambio de sensor.

Una imagen de resolución normal.

Profundizando

Considere un cuadrado de 2 × 2 píxeles en una fotografía digital creada con tecnología de desplazamiento de píxeles. La primera foto comienza normalmente con los datos registrados de los cuatro sitios de fotos. Sin embargo, ahora la cámara cambia el sensor para mover los sitios de fotos y vuelve a tomar la misma foto pero con un sitio de fotos diferente.

Repita este proceso para que todos los fotositos tengan toda la luz para cada punto exacto en el sensor. Durante este proceso, se adquirieron datos de luz de cuatro fotositos (dos verdes, uno rojo y uno azul) para cada píxel, lo que dio como resultado mejores valores de color para cada ubicación y menos necesidad de interpolación (suposiciones fundamentadas).

Una imagen de alta resolución con el mismo ISO, apertura y velocidad de obturación.

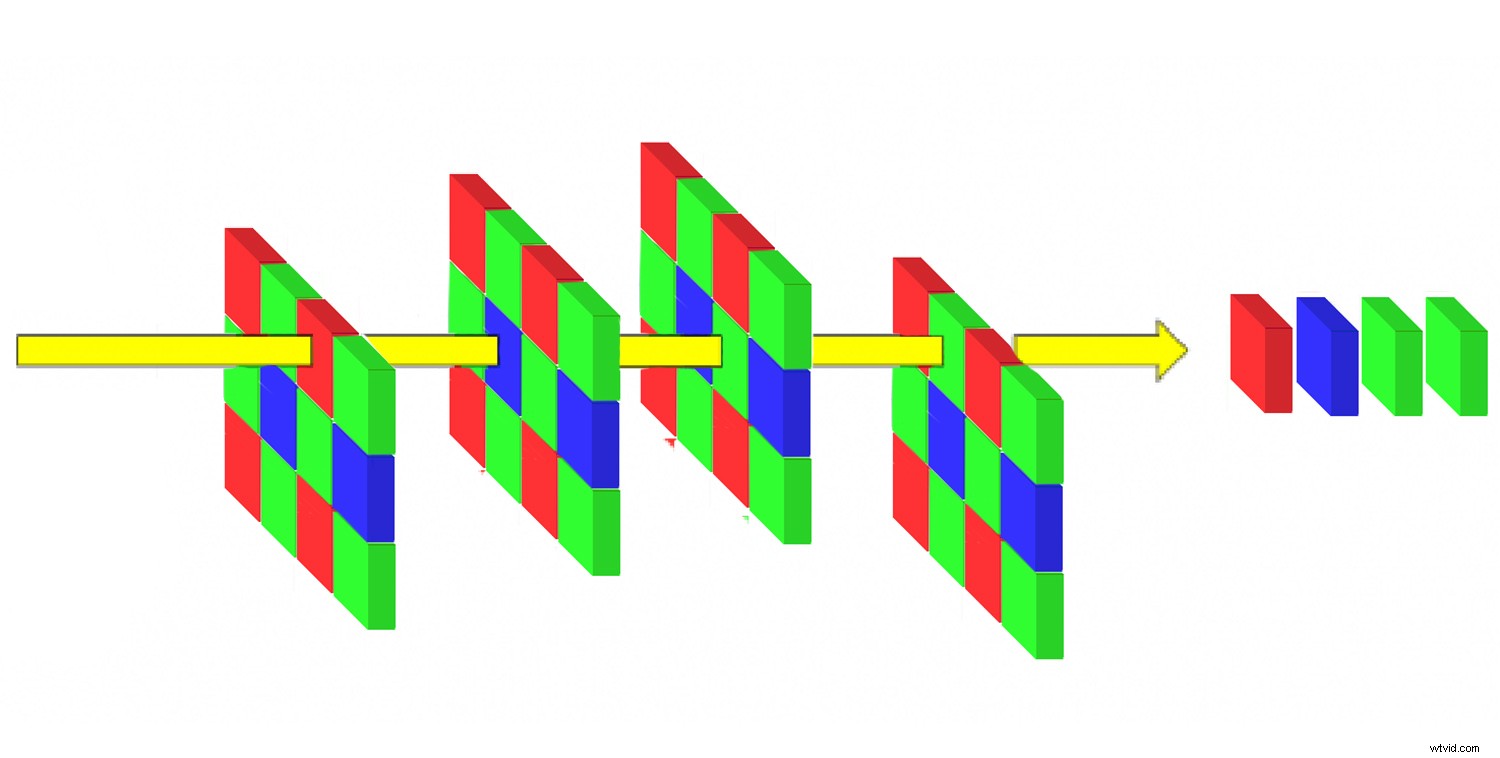

El enfoque de Sony y Pentax

El modo de disparo múltiple con cambio de píxeles de Sony y el sistema de resolución con cambio de píxeles de Pentax funcionan de esta manera. Es importante tener en cuenta que el uso de estos modos no aumenta el número total de píxeles de la imagen final. Las dimensiones de los archivos resultantes siguen siendo las mismas, pero se mejoran la precisión del color y los detalles.

Sony y Pentax toman cuatro imágenes y mueven un sitio de fotos completo por imagen para crear una sola imagen. Realmente es simplemente mejorar la información de color en la imagen.

El enfoque de Olympus y Panasonic

El modo de alta resolución de las cámaras Panasonic y Olympus, que utilizan sensores Micro Four Thirds, adopta un enfoque un poco más matizado, combinando ocho exposiciones tomadas con ½ píxel de diferencia entre sí. A diferencia de Sony y Pentax, esto aumenta significativamente la cantidad de píxeles en la imagen resultante.

Desde un sensor de 20 megapíxeles, obtienes una imagen RAW de 50-80 megapíxeles. Solo hay una imagen sin posibilidad de acceder a las imágenes individuales de una secuencia.

¿Cuáles son las ventajas de usar Sensor-Shift?

El uso de la tecnología de cambio de sensor tiene varias ventajas. Al tomar varias imágenes, conocer la información de color de cada ubicación de la foto y aumentar la resolución, se logran tres cosas principales. Disminuye el ruido, reduce el muaré y aumenta la resolución general de las imágenes.

Ruido y resolución mejorada

Al tomar varias imágenes con un cambio sutil en la posición del sensor, la resolución de la imagen aumenta, pero también lo hace la información de color de las imágenes. Esto permite imágenes similares para permitir una mayor profundización en la imagen con colores más suaves, menos ruido y mejor detalle.

Una imagen de resolución normal.

Una imagen de alta resolución.

Recortada en la imagen de resolución normal, comienza a ver ruido que aparece como variación de grano y color.

Aquí está el mismo recorte en la versión de alta resolución, el color y los detalles son mejores con menos ruido.

Menos muaré

Muaré es la aparición de patrones de ruido o artefactos que aparecen en imágenes con patrones regulares ajustados. Los sensores más nuevos tienden a tener menos problemas con Moire que en el pasado, pero seguirá apareciendo en algunas imágenes.

La causa del muaré tiende a estar relacionada con los patrones ajustados que se están grabando y la cámara tiene problemas para resolver el patrón porque tiene problemas con los patrones del fotosito del sensor. La información de color para los sitios de fotos rojo, verde y azul tiene problemas con los bordes en estos patrones ajustados porque no se registra todo el color de una sola ubicación.

Con el cambio de sensor, todo el color de cada ubicación está ahí, por lo que el muaré tiende a desaparecer.

Imagen de resolución normal.

Imagen de alta resolución con área de recorte resaltada

El área recortada en la imagen de resolución estándar:empieza a aparecer ruido (los arañazos en el papel estaban allí antes).

La imagen de mayor resolución tiene menos ruido y más detalles.

Entonces, ¿por qué no usar esto para cada imagen?

Bueno, la razón principal es que tienes que tomar varias imágenes de una sola escena. Esto significa que esto realmente no funciona bien para sujetos en movimiento. El proceso requiere, como mínimo, cuatro veces el tiempo de exposición de la captura de una sola imagen. Esto se traduce en cuatro oportunidades para que una parte de su composición y/o su cámara se muevan durante la captura de la imagen, degradando la calidad de la imagen.

Tales restricciones limitan la aplicación de la tecnología a la fotografía de naturaleza muerta y paisaje (estática). Cualquier movimiento en la escena que se captura creará un área borrosa o pixelada. Este es un problema para la fotografía de paisajes si hay viento que mueve plantas o nubes, así como áreas donde hay agua corriente.

Esto también significa que, por lo general, debe ser muy estable y usar un trípode, aunque hay algunas intenciones claras de los fabricantes de ofrecer versiones que permitan disparar con la cámara en la mano (Pentax tiene esta función).

Imagen de alta resolución tomada con un trípode.

Los artefactos de movimiento son visibles cuando se ven más de cerca.

Peculiaridades de algunos de los sistemas

Como la tecnología de cambio de sensor se ha implementado de diferentes maneras y según el sistema utilizado, los problemas son un poco diferentes. La peculiaridad principal es que generalmente necesitas un trípode, así que no corres y disparas.

El sistema de Sony tiene otras limitaciones:no puede ver la imagen hasta que procese las cuatro imágenes separadas juntas. Esto significa que no puede revisar su imagen resuelta en la cámara. Además, debido a la gran cantidad de píxeles de la A7R mark III, cualquier movimiento sutil del trípode se nota especialmente en la imagen resultante. Para editar las imágenes, también debe usar el software propietario de Sony para fusionar las imágenes.

Pentax tiene algunas características interesantes. El uso de la aplicación de software que viene con la cámara permite abordar el movimiento mediante el uso de un algoritmo dentro del software para eliminar los artefactos de movimiento. Esto funciona mejor que el software comúnmente utilizado para la manipulación de imágenes, como Adobe.

El sistema Olympus ha existido por un tiempo y en la iteración más reciente en el Olympus OMD EM1 Mark II, cualquier movimiento detectado hará que los píxeles afectados se reemplacen con partes de una de las imágenes únicas de resolución regular en las áreas de movimiento. Esto crea una resolución desigual pero hace que la imagen se vea mejor para cosas como el viento. También tiene limitaciones, especialmente si hay mucho movimiento. A menudo, las imágenes se ven un poco pixeladas.

Imagen de resolución estándar de un árbol:todo es nítido.

Una imagen de alta resolución del mismo árbol pero con viento... El área recortada se muestra en el cuadro amarillo.

Área recortada expandida:el movimiento del viento generó algunos artefactos en la imagen.

Limitaciones

El mayor desafío al que se enfrenta la captura de imágenes con desplazamiento de sensor son los sujetos en movimiento. Además, tratar de emparejar una luz estroboscópica con una cámara mediante la captura de imágenes con desplazamiento de píxeles puede complicarse debido a la velocidad de captura de imágenes, las limitaciones de reciclaje del flash y los problemas generales de compatibilidad. Los fabricantes son conscientes de estos problemas y están trabajando para resolverlos.

En general, la tecnología solo va a mejorar

Cada vez más sistemas utilizan algoritmos para producir estas imágenes de mayor resolución. A medida que la tecnología madure, las implementaciones obtendrán mejores y mejores resultados, potencialmente capaces de lidiar con el movimiento y las condiciones de mano.

La ventaja para los fabricantes es que se producen imágenes de mejor calidad sin necesidad de sensores de alta densidad de píxeles realmente caros (más baratos). Las ventajas para el usuario son que las imágenes pueden tener mejor información de ruido y color para obtener mejores resultados finales.

¡Feliz búsqueda de esa imagen perfecta de alta resolución!